La reconnaissance faciale et la surveillance par IA se répandent rapidement, des aéroports aux hôpitaux, en passant par les Smart Cities et les appareils personnels. Bien que ces outils promettent un renforcement de la sécurité et un gain d’efficacité, ils soulèvent également des préoccupations majeures en matière de protection de la vie privée, de consentement et de biais algorithmique.

Source du texte: CSEM, traitement rédactionnel, Domotech

Photos: @CSEM

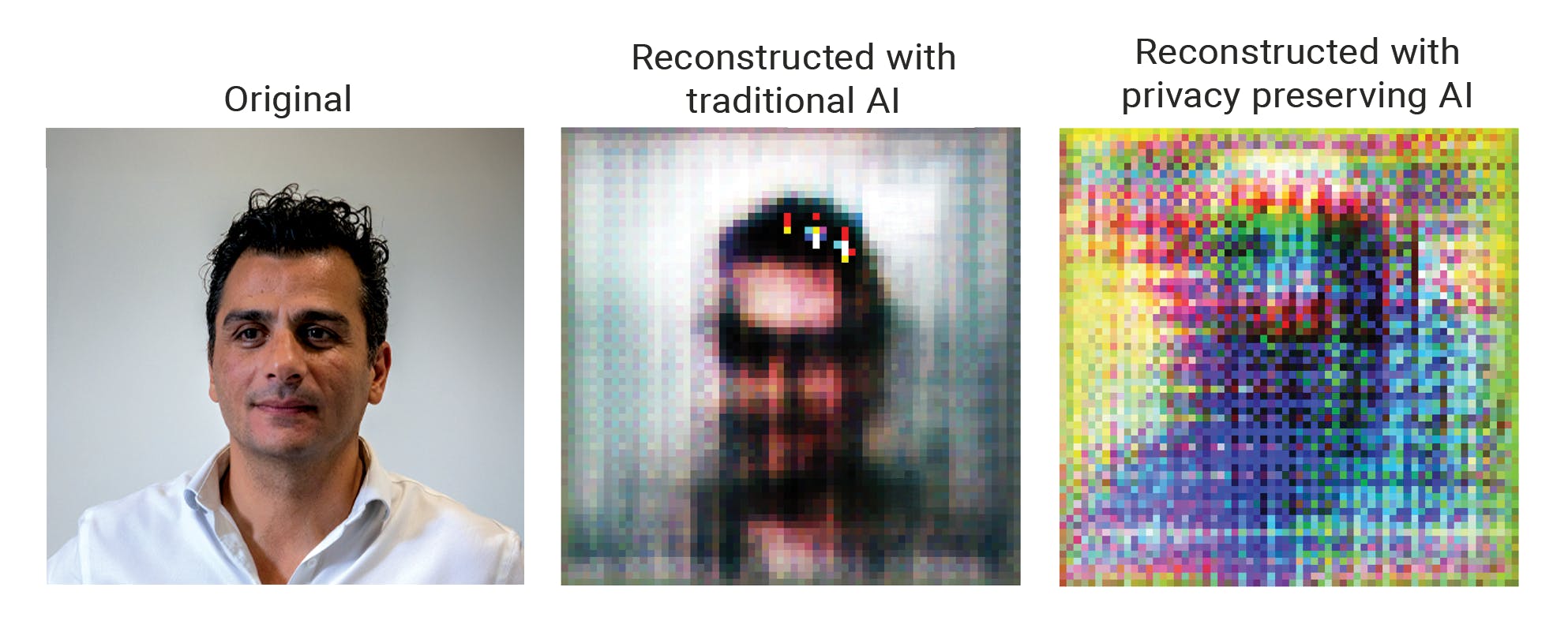

Le CSEM a mis au point une nouvelle méthode puissante d’entraînement de l’IA qui permet de surveiller la population (par exemple dans les espaces publics ou les hôpitaux) tout en protégeant la vie privée des individus et en évitant les préjugés. La méthode s’appuie sur une stratégie astucieuse d’« apprentissage antagoniste », qui introduit un réseau dit de « chiens de garde » pendant la phase d’entraînement de l’IA.

Ce challenger interne détecte lorsque le système tente de conserver des informations qu’il ne devrait pas (comme l’âge d’une personne) et le force à oublier. Résultat : une IA capable de surveiller les flux de foule, de détecter les anomalies de santé ou d’aider à contrôler les accès sans jamais enregistrer l’identité des personnes.

Performance et protection : pas besoin de compromis

Développée par le groupe Edge AI and Vision Systems du CSEM, cette innovation a été testée à l’aide de données médicales et d’images faciales. Cet essai a montré que les modèles formés avec la méthode de protection de la vie privée étaient encore meilleurs que les systèmes d’IA traditionnels, améliorant la précision des tâches de jusqu’à 6,7%. Plus important encore, ils se sont avérés résistants aux attaques modernes contre la vie privée, y compris les tentatives de rétro-ingénierie à partir des paramètres des modèles. Ces résultats ont été présentés récemment lors de la 22e Conférence internationale sur l’informatique distribuée et l’intelligence artificielle (DCAI) en France.

Pour résumer : aucune donnée sensible n’a besoin d’être stockée, transmise ou même vue par le système. Cette approche permet de déployer l’IA en toute sécurité dans des secteurs comme la santé, la sécurité publique, la mobilité urbaine et l’électronique grand public.

Pertinence mondiale de la technologie de reconnaissance faciale

La technologie de reconnaissance faciale (FRT) progresse rapidement. Des systèmes comme Meta’s Deep Face atteignent désormais la même précision que l’homme. En 2024, la police britannique a scanné plus de 4,7 millions de visages à l’aide de la reconnaissance faciale en direct, contribuant à des centaines d’arrestations. Un sondage réalisé en 2020 aux États-Unis a révélé que 66% des personnes sont favorables à l’utilisation de la FRT dans le cadre du maintien de l’ordre.

Pourtant, des préoccupations majeures subsistent. La précision varie encore considérablement d’un groupe à l’autre, avec des taux d’erreur pouvant atteindre 34,7% chez les femmes à la peau foncée contre 0,8% chez les hommes à la peau claire. La confiance du public est partagée, surtout lorsque des acteurs commerciaux ou étatiques sont impliqués.

Les gouvernements du monde entier réagissent. La Chine a mis en place des règles de transparence et de consentement. L’UE est en train de mettre la dernière main à sa loi sur l’intelligence artificielle. Parallèlement, la Suisse adopte une approche sectorielle en intégrant la supervision de l’IA aux structures juridiques existantes.

Suisse : la réglementation se renforce, l’innovation fournit des réponses

La loi fédérale suisse révisée sur la protection des données (LPD), en vigueur depuis septembre 2023, classe les données biométriques comme hautement sensibles. Comme l’a confirmé le Commissaire fédéral à la protection des données et à l’information, la reconnaissance faciale en temps réel à grande échelle dans les espaces publics est effectivement interdite en l’absence de justification juridique spécifique.

Dans une pétition de 2021, les Suisses ont réclamé une interdiction nationale de la reconnaissance faciale dans le cadre de la surveillance, et 80% des candidats au Parlement se sont prononcés en faveur de contrôles plus stricts en 2023. Les initiatives cantonales progressent également : Neuchâtel a inscrit « l’intégrité numérique » dans sa constitution, Saint-Gall pilote les signatures électroniques et Lausanne poursuit des réformes de la gouvernance numérique.

L’IA respectueuse de la confidentialité conçue par le CSEM est prête à être déployée

La méthode du CSEM appuie ce cadre réglementaire en veillant à ce que l’IA ne conserve ou ne traite jamais de données personnelles sensibles, réduisant ainsi les risques d’abus, de profilage et d’atteinte à la vie privée. La technologie est compacte, économe en énergie et idéale pour une utilisation dans des systèmes embarqués. Elle garantit que les systèmes d’IA apprennent uniquement ce dont ils ont besoin pour leur mission.

Grâce à cette approche, les données personnelles n’ont pas à être stockées ni transmises. Le système « désapprend » activement l’identité des personnes et se concentre uniquement sur ce qui compte, ce qui le rend idéal pour des applications responsables dans les domaines de la santé, de la sécurité et des services publics. La technologie est testée, opérationnelle et prête à être déployée dès aujourd’hui.

Ces articles pourraient également vous intéresser

Mentions légales

Source du texte: CSEM

Source de l'image: CSEM

Informations

Autres articles

- IA éthique

- innovation responsable

- protection des données

- reconnaissance faciale

- technologie et vie privée

Veröffentlicht am: